随着AI算力爆发式增长和数据中心功率密度持续攀升,传统风冷技术已难以满足散热需求,液冷技术凭借高效散热、节能降耗等优势成为必选项。在液冷技术中,冷板式与浸没式两大路径的竞争尤为激烈。本文将从技术特性、应用场景、成本经济性及未来趋势等角度解析两者的优劣势,并探讨其未来主导方向。

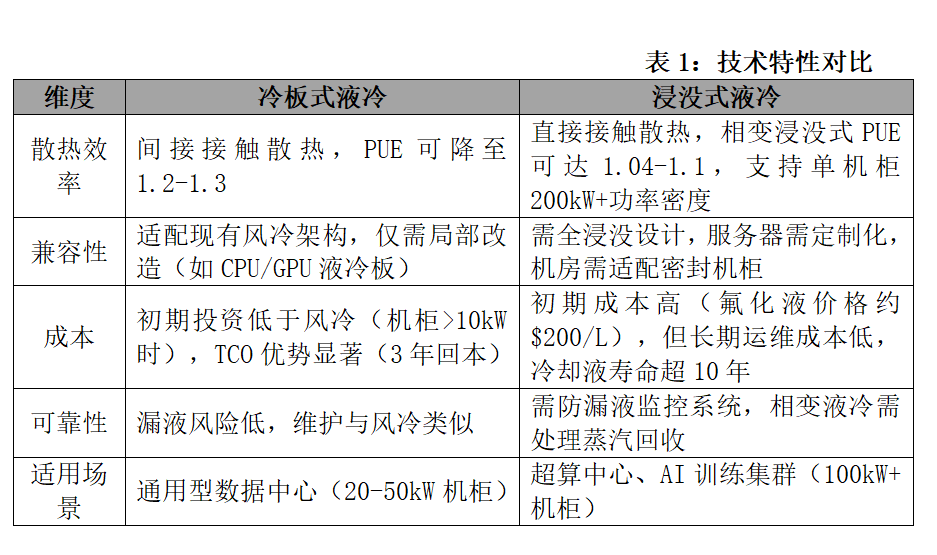

1-技术特性对比:冷板式兼容性强,浸没式散热效率更高

a.冷板式液冷:平滑过渡的“改良派”

兼容性强:无需对服务器结构进行大幅改造,可兼容现有风冷数据中心的基础设施,改造成本低、周期短。

安全性高:冷却液不与电子元件直接接触,泄漏风险较低,且可通过模块化设计(如快换接头、冗余管路)进一步降低风险。

成熟度高:冷板式技术已广泛应用于阿里云千岛湖数据中心、英特尔合作项目等场景,占据当前液冷市场90%的份额。

局限性:冷板式仅能覆盖部分高功耗部件(如CPU、GPU),其余热量仍需依赖风冷辅助散热,PUE值通常在1.1-1.2,略高于浸没式。

b.浸没式液冷:高效散热的“革新派”

浸没式液冷将服务器完全浸没于绝缘冷却液中,通过直接接触实现全器件散热。其核心优势包括:

极致能效:液体导热系数是空气的20-30倍,PUE可低至1.05,散热效率提升3倍以上。

空间节省:冷却系统体积仅为风冷的1/3,单机柜功率密度可达50kW以上,适合AI超算等高密场景。

静音环保:无需风扇,噪音降低90%以上,且无灰尘污染,延长设备寿命。

挑战:浸没式需定制化服务器、冷却液成本占比高达60%(如氟化液),且初期投资较高,生态兼容性待完善。

2-应用场景分化:中短期冷板式主导,长期浸没式潜力释放

a.冷板式:存量改造与新建IDC的“性价比之选”

老旧数据中心改造:冷板式可快速适配现有风冷架构,改造周期短、成本可控。例如,英特尔与比赫合作的模块化方案,通过标准化冷板设计降低部署难度。

中高密度算力场景:冷板式已支持单机柜130-250kW功率(如英伟达B系列GPU),满足多数AI训练需求。

b.浸没式:超算与绿色数据中心的“终极方案”

超高密度算力:下一代芯片(如英伟达Rubin系列)机柜功率将突破1000kW,浸没式成为唯一可行方案。

绿色节能需求:浸没式PUE逼近1.05,余热回收效率达90%(如联想方案),契合“双碳”目标政策。

c.市场格局现状

冷板式主导当前市场:2025年冷板式占液冷市场80%-90%,浸没式不足10%。并且已形成标准化接口(如英特尔的OCP冷板设计),浪潮、中科曙光等厂商方案兼容性强。国内“东数西算”工程要求新建数据中心PUE≤1.25,冷板式成为过渡首选。

浸没式蓄势待发:曙光数创C8000相变浸没方案实现PUE 1.04,阿里云“麒麟”数据中心验证单相浸没可行性。 英伟达B200 GPU(1000W+)等高功耗芯片倒逼浸没式应用,液冷算力密度提升30%-50%。 欧盟计划2028年禁用氟化液,国内碳氢/硅油冷却液研发加速(如中石化“昆仑”系列)。

3-权威观点PK

冷板派:冷板式是液冷普及的‘破冰者’,未来5年仍将承担80%液冷增量市场,浸没式需等待芯片功耗突破临界点。

浸没派:相变浸没是液冷的终极形态,冷板式仅是过渡方案。当单芯片功耗超800W时,浸没式将成为唯一选择。

中立派:技术路线分化反映算力需求分层,冷板服务‘东数’,浸没支撑‘西算’,双轨并行是未来十年主旋律。

4-行业机遇与策略

成本与生态博弈:冷板式短期占优,浸没式需降本破局。

冷板式:优化材料(铜铝复合)、提升加工精度(防泄漏工艺),推动模块化与标准化设计。

浸没式:研发高性价比冷却液(如单相浸没液)、兼容性机柜,联合芯片厂商定制散热方案。

技术储备:探索两相流冷板、智能监控系统(如AI动态调流),应对未来高功率需求。

5-结论

短期(2025-2027):冷板式主导通用场景,浸没式渗透率提升至15%-20%;长期(2030+):相变浸没式在高算力领域成为主流,冷板式退守中低密度市场。

胜负手:冷却液成本、芯片功耗跃升速度、国际环保政策。

我们会定期更新有关热设计与轻量化的技术与资讯,与您分享,供您参考,感谢您对迈泰的关注。